최근 몇 달간 전 세계를 뜨겁게 달군 이슈는 ChatGPT의 등장일 것이다. ChatGPT는 Open AI에서 개발한 대화형 인공지능 언어 모델로 인터넷에 올라온 방대한 데이터를 학습해 질문자가 질문을 던지면 축적한 데이터를 바탕으로 문장을 만들어 대답한다. 이런 AI의 등장은 번역, 법률 문서 작성, 심지어 간단한 형태의 코딩까지 사람이 직접 할 수밖에 없던 많은 일을 대체할 가능성을 보여줬다. 그러나 그 정체성과 진실성에 진지하게 의심의 눈초리로 쳐다보는 시선도 생기고 있다. 누군가는 헛소리를 그럴듯하게 하는 프로그램일 뿐이라며 평가절하하기도 한다.

이런 의심의 배경에는 ChatGPT의 부정확한 대답이 있다. 사람이 던진 질문에 ChatGPT가 대답하는 방식은 학습된 방대한 데이터를 바탕으로 그저 확률적으로 적절해 보이는 단어, 문장의 조합을 제공하는 것에 불과하다. 사람이 말하는 방식과는 큰 차이가 있다. 이런 AI의 한계에 노암 촘스키는 최근 기고문을 통해 “인공지능은 인간 단계의 초입에조차 이르지 못했다”라고 표현했다. 인간 단계에 다다른다는 것은 인간과 같이 스스로 사고하고 판단할 수 있게 된다는 것을 의미한다.

그러나 판단을 떠넘기기 위한 것이 아니라 지식을 함양하고 사고를 확장하는 목적으로 활용한다면 ChatGPT는 혁신적이다. 최근 친구들과 ChatGPT를 연구에 활용할 방안을 고민했는데 여러 시도를 통해 지식과 직관을 얻을 수 있는 새로운 경로를 발견했다. 처음에는 관련 사항에 대한 일반적인 사실을 묻고, 좀 더 구체적인 배경, 근거들을 물으며 제시된 근거가 무엇인지 정리했다. 이를 통해 한 연구 영역의 지도를 빠르게 그릴 수 있었다. 그 후에 ChatGPT가 제시한 정보가 옳은 것인지 재검토하는 과정을 통해 정확성까지도 높일 수 있었다.

ChatGPT가 오류를 포함하고 있다는 것을 우려하지만, 인간이 만들어온 많은 자료에도 오류는 이미 포함돼 있다. 인간은 자연과 사회로부터 많은 정보를 습득하고, 이를 해석하고, 또다시 기록으로 남기며 지식을 체계화하며 발전했다. 그런데 인간이 바라보는 세상은 부정확하고 뚜렷하지 않은 경우가 일반적이며, 인간의 시선에서 쓰인 기록 역시 마찬가지다. 헤로도토스는 역사학의 아버지라 불리지만 때로 거짓말의 아버지라고도 불렸다. 그것은 그가 정확한 역사적 사실만을 기술했던 것이 아니라 때로는 과장하고, 고대 그리스인의 편견을 반영했으며, 자기 자신도 신뢰할 수 없는 풍문까지도 기록했기 때문이다. 아이러니하게도 헤로도토스의 잘못된 지식은 자신이 판단하기에 정확한 내용만 담으려 했던 역사가보다 후대에 더 많은 진실을 남겼다. 중요한 것은 오류를 구분해 낼 수 있는 사람의 능력이다.

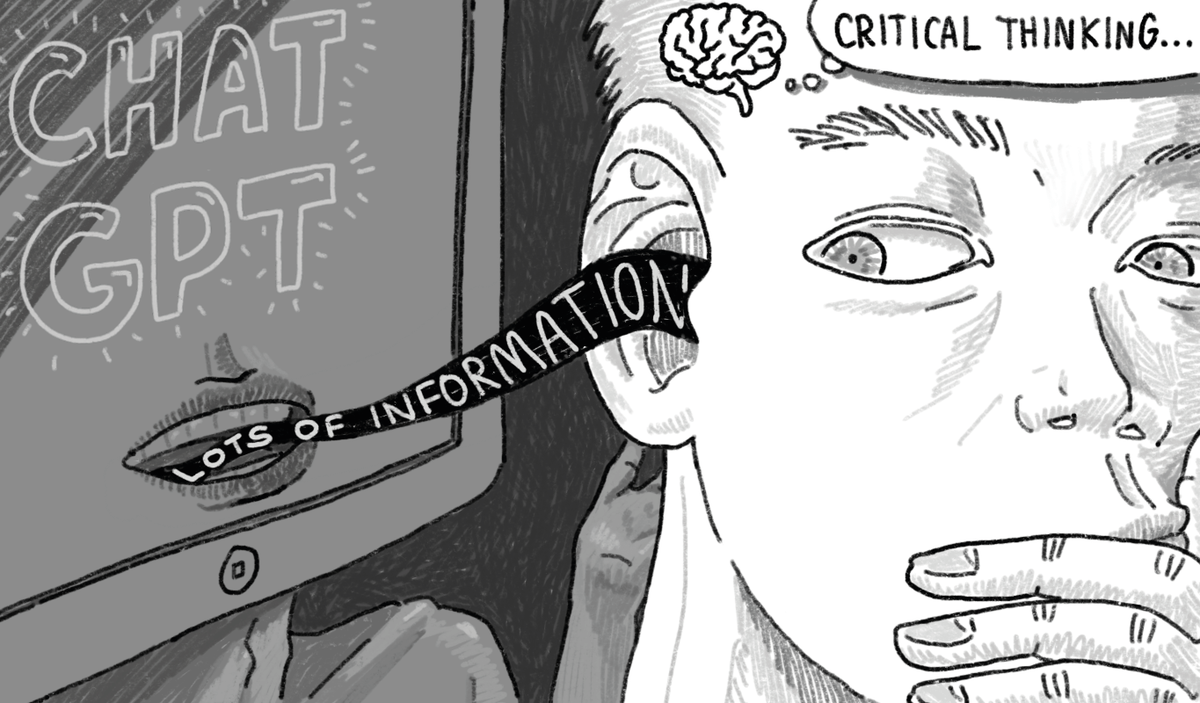

AI는 우리를 인도하는 마법의 지팡이가 아니며 우리의 방향성도 제시하지 못한다. AI에 대한 우려는 AI가 오류를 포함해서가 아니라 그것에 인간을 대체하는 지위를 부여하려 하기 때문이다. 헤로도토스의 예시는 우리는 이미 부정확한 지식 속에서 이를 비판적으로 받아들여 해석해 왔고, 이것이 인간지능의 핵심이라는 것을 보여준다. 세상을 끊임없이 재해석하고 의미를 발견해 나가는 것은 외주를 줄 수 없는 인간 본연의 역할이자 숙명이다.

삽화: 신윤서 기자

oo00ol@snu.ac.kr